Mit Web-Scraping können Daten aus Webseiten extrahiert werden und z.B. in eine Anwendung wie Excel importiert werden. Sie eignet sich besonders gut, automatisierte Auswertungen aus Webseiteninhalten in eine Excel Tabelle zu übertragen. Die in Excel enthaltene Programmiersprache VBA (Visual Basic for Applications) eignet sich sehr gut, um per Web-Scraping Verfahren Daten von Webseiten abzugreifen und später in Excel weiter zu verarbeiten. In diesem Blogbeitrag werden wir detailliert darauf eingehen, wie Web-Scraping funktioniert und auch eine Beispielanwendung anhand eines fertigen VBA-Skriptes zeigen.

Einleitung

Daten sind heutzutage das neue Gold, so wird oftmals behauptet. Anhand von Daten können Unternehmen oder auch einzelne Personen fundierte Entscheidungen treffen. Je mehr Daten vorliegen, desto einfacher wird dieser Vorgang. Besonders im Bereich der KI spielt die Datenmenge eine entscheidende Rolle. Mit Web-Scraping können auch unstrukturierte Daten von Webseiten automatisch ausgelesen und in andere Dateiformate umgewandelt oder importiert werden.

Was ist Web-Scraping?

Web-Scraping ist der Vorgang um automatisiert Daten von anderen Quellen, in diesem Fall Webseiten, zu sammeln. In der Regel erfolgt die Extraktion der Daten per Programm oder Skripte, die HTML-Seiten aufrufen, analysieren und die vorher festgelegten Daten aus der Webseite extrahieren. Da dieses Verfahren automatisiert ablaufen kann, sind vom Anwender keine manuellen Schritte notwendig.

Warum Excel für Web-Scraping verwenden?

Excel eignet sich hervorragend für Web-Scraping Skripte. Mit VBA, dem integrierten Entwicklungstool für Visual Basic Skripte, wird dem Anwender eine einfache, aber hervorragende Möglichkeit zur Datenextraktion geboten. Mit Hilfe von Makros können Sie keine Anwendungen erstellen, die gewünschte Daten aus beliebigen Webseiten auslesen und in Excel Dateien importieren. Mit Excel ist es ebenfalls möglich, diese Skripte zeitgesteuert automatisiert ablaufen zu lassen. Hier nachfolgend noch einige weitere Vorteile, die Excel für Web-Scraping Projekte bietet:

- Verfügbarkeit: Excel ist auf den meisten Computern installiert und leicht zugänglich.

- Benutzerfreundlichkeit: Die Lernkurve für VBA ist im Vergleich zu anderen Programmiersprachen relativ flach.

- Integration: Excel ermöglicht die direkte Weiterverarbeitung und Analyse der gescrapten Daten.

- Flexibilität: VBA kann angepasst werden, um eine Vielzahl von Web-Scraping-Aufgaben zu erledigen.

Voraussetzungen um Web-Scraping anzuwenden

Bevor wir anfangen, benötigen Sie:

- Microsoft Excel (idealerweise die neueste Version)

- Grundkenntnisse in VBA

- Zugang zum Internet

Grundlagen von VBA in Excel

Bevor wir in das Web-Scraping eintauchen, ist es wichtig, einige grundlegende Konzepte von VBA zu verstehen.

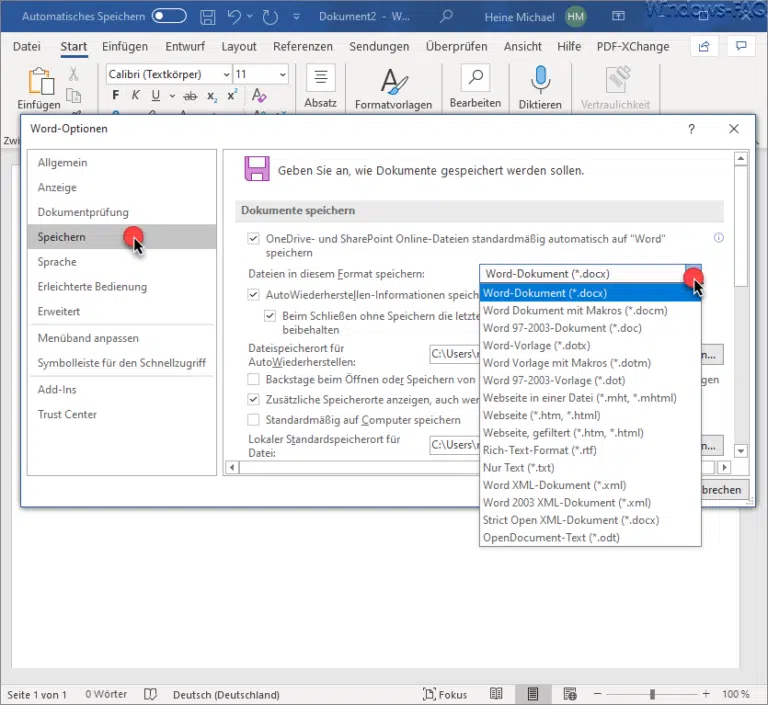

1. Aktivieren der Entwicklertools

- Öffnen Sie Excel und gehen Sie zu den Optionen.

- Wählen Sie „Menüband anpassen“ und aktivieren Sie das Kontrollkästchen „Entwicklertools“.

- Ein neuer Tab „Entwicklertools“ wird im Menüband angezeigt.

2. Makrorekorder

Excel bietet einen Makrorekorder, der Ihre Aktionen aufzeichnet und sie in VBA-Code umwandelt. Dies ist ein guter Ausgangspunkt für Anfänger.

3. Das VBA-Editorfenster

- Klicken Sie auf den Tab „Entwicklertools“ und dann auf „Visual Basic“.

- Das VBA-Editorfenster wird geöffnet, wo Sie Ihren Code schreiben und bearbeiten können.

Erste Schritte mit Web-Scraping in Excel

Lassen Sie uns nun einen einfachen Web-Scraping-Prozess mit Excel und VBA durchführen.

1. Einfache Datenextraktion

Unser erstes Beispiel ist die Extraktion von Daten von einer statischen Webseite. Nehmen wir an, wir möchten die Titel der neuesten Blogbeiträge von einer Webseite extrahieren.

- Öffnen Sie den VBA-Editor.

- Fügen Sie ein neues Modul ein (Einfügen > Modul).

- Schreiben Sie den folgenden Code:

Sub SimpleWebScrape()

Dim ie As Object

Dim html As Object

Dim post As Object

Dim postTitle As String

Dim row As Integer

' Internet Explorer öffnen

Set ie = CreateObject("InternetExplorer.Application")

ie.Visible = False

ie.navigate "https://www.windows-faq.de"

' Warten bis die Seite geladen ist

Do While ie.Busy Or ie.readyState <> 4

DoEvents

Loop

' HTML-Dokument extrahieren

Set html = ie.document

' Titel der Blogposts extrahieren

row = 1

For Each post In html.getElementsByClassName("post-title entry-title")

postTitle = post.innerText

Cells(row, 1).Value = postTitle

row = row + 1

Next post

' Internet Explorer schließen

ie.Quit

Set ie = Nothing

End SubErklärung des Web-Scraping Codes:

- Wir verwenden „CreateObject„, um eine neue Instanz des Internet Explorers zu erstellen.

- Mit „ie.navigate“ navigieren wir zur gewünschten Webseite, in unserem Beispiel „www.windows-faq.de„.

- Wir warten, bis die Seite vollständig geladen ist, bevor wir fortfahren.

- Mit „ie.document“ erhalten wir das HTML-Dokument der Seite.

- Wir suchen nach Elementen mit der Klasse „post-title entry-title“ und extrahieren deren Text. Dieser Bereich muss je nach Webseite an den korrekten „Classname“ angepasst werden.

- Schließlich schließen wir den Internet Explorer und beenden das Makro.

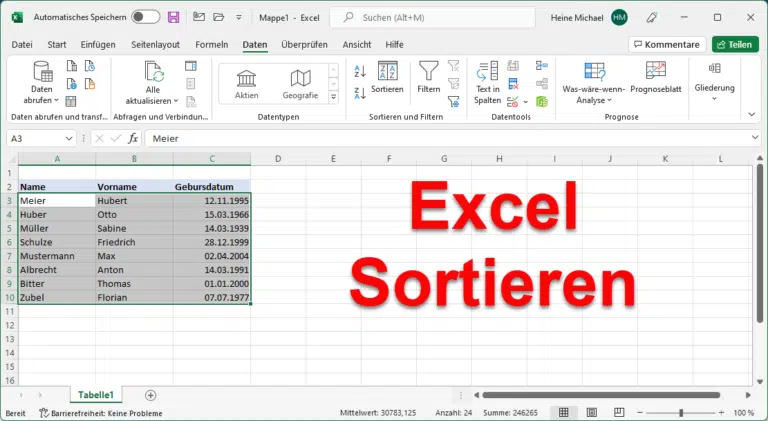

Wenn wir diesen Web-Scraping Code dann in der VBA Entwicklungsumgebung von Excel ausführen, so liest das Skript automatisiert die neuesten TItel aller Blogbeiträge unserer Windows-FAQ.de Webseite aus und schreibt sie in ein Excel-Arbeitsblatt.

Umgang mit HTML-Strukturen

HTML ist die Markup-Sprache, die zur Erstellung von Webseiten verwendet wird. Beim Web-Scraping ist es wichtig, die Struktur von HTML zu verstehen, um gezielt Daten extrahieren zu können. Grundlegende Kenntnisse über Tags, Attribute und die DOM-Struktur (Document Object Model) sind dabei hilfreich.

Daten Extraktion mit professionellen Tools und Aufgabenvorlagen

Neben der Verwendung von VBA in Excel gibt es spezialisierte Tools, die den Prozess des Web-Scrapings erheblich vereinfachen können. Eines dieser Tools ist Octoparse, eine leistungsstarke Web-Scraping-Software, die sowohl für Anfänger als auch für fortgeschrittene Benutzer geeignet ist. Octoparse bietet eine intuitive, visuelle Oberfläche, mit der Sie ohne Programmierkenntnisse Daten von Webseiten extrahieren können. Ein besonders nützliches Feature von Octoparse sind die Aufgabenvorlagen, die bereits vordefinierte Workflows für verschiedene Arten von Web-Scraping-Aufgaben bieten.

a. Was sind Aufgabenvorlagen?

Aufgabenvorlagen in Octoparse sind vorkonfigurierte Scraping-Workflows, die für spezifische Webseiten und Anwendungsfälle entwickelt wurden. Diese Vorlagen sind so gestaltet, dass sie direkt verwendet werden können, ohne dass der Benutzer die Struktur der Webseite analysieren oder komplexe Workflows erstellen muss. Mit nur wenigen Klicks können Sie eine Vorlage auswählen, anpassen und sofort Daten extrahieren.

b. Vorteile der Verwendung von Aufgabenvorlagen

- Zeitersparnis: Da die Vorlagen bereits vorkonfiguriert sind, sparen Sie sich die Zeit und den Aufwand, die erforderlich wären, um einen Scraping-Workflow von Grund auf neu zu erstellen.

- Benutzerfreundlichkeit: Die Vorlagen sind so gestaltet, dass sie auch von Benutzern ohne technische Kenntnisse verwendet werden können. Sie müssen lediglich einige Parameter anpassen, wie z.B. den Suchbegriff oder die Anzahl der Seiten, die gescrapt werden sollen.

- Hohe Erfolgsquote: Da die Vorlagen von Experten entwickelt wurden, sind sie in der Regel sehr robust und haben eine hohe Erfolgsquote beim Scraping der vorgesehenen Webseiten.

- Regelmäßige Updates: Die Vorlagen werden regelmäßig aktualisiert, um sicherzustellen, dass sie mit den neuesten Änderungen an den Webseiten kompatibel bleiben.

c. Beispiele für Aufgabenvorlagen

Octoparse bietet eine Vielzahl von Aufgabenvorlagen für verschiedene Branchen und Anwendungsfälle. Hier sind einige Beispiele:

- Amazon-Produktinformationen: Eine Vorlage, die Produktdetails wie Preis, Titel, Bewertungen und mehr von Amazon extrahiert.

- Immobiliendaten: Diese Vorlage sammelt Informationen über Immobilienangebote von Plattformen wie Zillow oder Immoscout24.

- Gelbe Seiten: Die Vorlage ermöglicht Daten Scraping von Gelbe Seiten Daten nach URLs.

- Börsenkurse: Eine Vorlage zur Extraktion von aktuellen Aktienkursen und Marktdaten von Finanzwebseiten.

- Jobangebote: Eine Vorlage, die Joblisten von Seiten wie Indeed, LinkedIn oder der Arbeitsagentur extrahiert, einschließlich Titel, Unternehmen, Standort und mehr.

d. Wie man eine Aufgabenvorlage verwendet

Der Prozess zur Verwendung einer Aufgabenvorlage in Octoparse ist einfach:

- Registrierung und Download: Registrieren Sie sich auf der Octoparse-Website und laden Sie die Software herunter.

- Auswahl der Vorlage: Gehen Sie zur Vorlagenbibliothek und wählen Sie die Vorlage aus, die am besten zu Ihrem Anwendungsfall passt.

- Anpassung: Passen Sie die Vorlage nach Bedarf an. Dies könnte das Einstellen des Startpunkts, die Anzahl der Seiten, die durchsucht werden sollen, oder das Hinzufügen von Filtern beinhalten.

- Ausführen der Aufgabe: Starten Sie die Aufgabe und lassen Sie Octoparse die Daten extrahieren. Die Daten können in verschiedenen Formaten wie Excel, CSV oder direkt in eine Datenbank exportiert werden.

- Speichern und Automatisierung: Sie können die Aufgabe speichern und automatisieren, sodass sie regelmäßig ohne Ihr Zutun ausgeführt wird.

e. Integration mit Excel

Nach der Extraktion können die Daten nahtlos in Excel importiert werden, wo Sie sie weiter analysieren und verarbeiten können. Octoparse bietet auch die Möglichkeit, Daten direkt in Google Sheets zu exportieren, was eine einfache Integration mit anderen Google-Diensten ermöglicht.

Herausforderungen und Lösungen

Web-Scraping ist nicht immer einfach und es gibt verschiedene Herausforderungen:

- Seitenstrukturen ändern sich: Webseiten werden häufig aktualisiert, was dazu führen kann, dass Ihr Scraping-Skript nicht mehr funktioniert.

- Captcha und Anti-Scraping-Techniken: Viele Webseiten implementieren Techniken, um automatisiertes Scraping zu verhindern.

- Rechtliche Aspekte: Es ist wichtig, die rechtlichen Implikationen des Web-Scrapings zu verstehen und sicherzustellen, dass Sie die Nutzungsbedingungen der Webseite einhalten.

Best Practices und rechtliche Aspekte

- Respektieren Sie die Nutzungsbedingungen: Lesen und respektieren Sie die Nutzungsbedingungen der Webseite, die Sie scrapen möchten.

- Nutzung von APIs: Wenn möglich, nutzen Sie offizielle APIs, die von der Webseite bereitgestellt werden.

- Rate-Limiting: Implementieren Sie eine Verzögerung zwischen den Anfragen, um die Serverlast zu minimieren und das Risiko einer Sperrung zu reduzieren.

- Dokumentation: Dokumentieren Sie Ihren Code und stellen Sie sicher, dass er leicht anpassbar ist, falls sich die Webseitenstruktur ändert.

Fazit

Excel bietet eine hervorragende Möglichkeit, um mit VBA Skripten Daten von Webseiten zu extrahieren und diese danach direkt in Excel weiter zu verarbeiten. Anhand des vorgestellten Skripts können Sie Daten von beliebigen Webseiten herausfiltern und in Ihre Excel-Dateien importieren. Sie sollten allerdings immer die rechtlichen Aspeckte berücksichtigen, wenn Sie per Web-Scraping Daten von anderen Datenquellen sammeln.

– Excel Zählenwenn

– Summenzeichen (Σ) in Excel

– Excel subtrahieren

– Excel Spalten zusammenführen

– Excel Checkbox einfügen

– Excel Kommentar einfügen, löschen & drucken

– Excel Duplikate entfernen

Neueste Kommentare