Das Internet verdrängt zunehmend die klassischen Vertriebswege kleiner und mittelständischer Unternehmen – wer heute nicht mindestens zweigleisig fährt, muss enorme Einschränkungen hinnehmen und hat keine Argumente gegenüber Interessenten. Setzt man sodann auf eine gut betreute Webseite, die womöglich einen Teil der Kundenverwaltung übernimmt und entsprechend Besucher aufweist, stellt ein Ausfall des Servers natürlich eine halbe Katastrophe dar. Große Unternehmen investieren sehr stark in sichere Technologie, widmen sich dem Thema Server-Überwachung.

Wir werden in diesem Beitrag nun verdeutlichen, welche Funktionen dahinterstecken und worauf es im Zweifelsfalle ankommt.

Die technischen Grundlagen

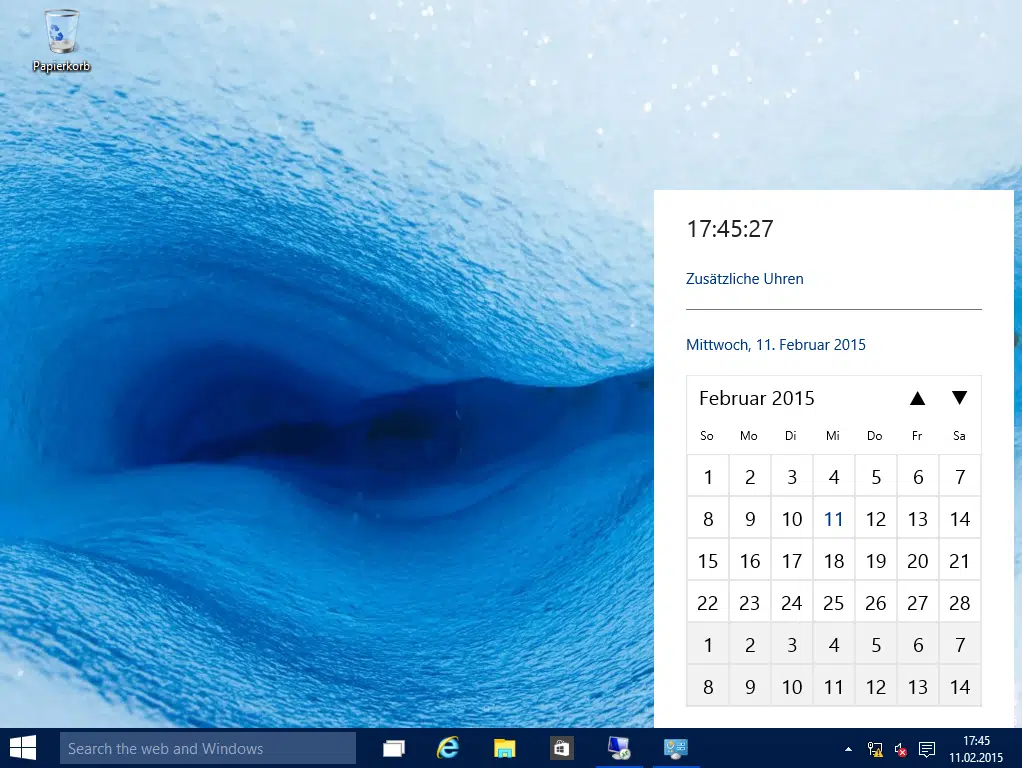

Bei regelmäßigen Tests und einem stabilem Monitoring kommt es darauf an, dass auch die Messwerkzeuge einwandfrei funktionieren und vor allem jederzeit erreichbar sind. Aus diesem Grunde verfügen professionelle und seriöse Unternehmen im Bereich der Server-Überwachung über sehr viele an unterschiedlichen Knotenpunkten des Internets installierte Messpunkte, um anhand der Auslastung ein möglichst genaues Resultat zu erzielen. Sofern also ein spezieller Dienst nicht mit OK antwortet, wird dieser zu einer sogenannten Wiederholungsprüfung vorgemerkt und das erste Signal ermittelt, um weitere Dienste einzuspeisen und eine mögliche Fehlanalyse auszuschließen. Das verhindert im konkreten Fall eine hohe Anzahl an Fehlalarmen, spart somit Kosten und Zeit ein.

Man bedient sich dabei vornehmlich Messpunkten in Deutschland und Frankreich, den USA, Japan und Russland. Hier gibt es gut gesicherte und höchst effektive Rechenzentren, die eine immerwährende Erreichbarkeit gewährleisten und belastbar sind.

Notwendige Prüfungsdienste

Im gewerblichen Bereich sind mittlerweile weitere Funktionen notwendig, um alle negativen Effekte der eigenen Webpräsenz zu vermeiden und Fehlern oder Ausfällen rechtzeitig vorbeugen zu können.

- Im Rahmen der Performanceüberwachung wird seitens des Anbieters sichergestellt, dass jegliche Funktionalitäten und webbasierten Dienste des Kunden erreichbar sind und dies in ausreichender Geschwindigkeit. Hierbei werden unterschiedliche Kennzahlen fortwährend überwacht, dokumentiert und automatisiert analysiert. Für eine zielgerichtete Herangehensweise empfiehlt sich der Gebrauch des HTTP Perf Dienstes. Dadurch werden Schwellwerte definiert, etwa die Bandbreite, Verbindungszeit und Antwortzeit – hiermit kann man gegenüber Mitbewerbern auftrumpfen und vermeidet einen Streuverlust aufgrund eines zu langsamen Seitenaufbaus oder Fehlverbindungen. Für weitere Dienste wie MYSQL, SMTP oder SSH lohnt sich eine Aufzeichnung ebenso, um die Verbindung zu wichtigen Datenbanken zu sichern und andere Ursachen ausschließen zu können. Hierzu bieten Qualitätsanbieter eine grafische Darstellung, inklusive einer Filterung der Daten nach Messpunkten sowie eine Auswertung des Perzentils und Berechnung von Durchschnittswerten.

- Zur Optimierung der Geschäftsprozesse kann man sich entweder emulierter Aktionen im Browser oder Anfragen über POST/GET an den Server bedienen. Bei der ersten Variante wird die reale Umsetzung über den Browser analysiert, inklusiver detaillierter Fehlerinformationen und dergleichen, wohingegen bei zweiter Variante die Transaktion simuliert wird und somit Fehler in bestimmten Abläufen oder Prozessen erkannt werden können.

Neueste Kommentare